OCLC News 79号

商品情報をはじめ、OCLCに関する様々な情報をご案内致します。

今号はAIを活用した重複排除の理念、メタデータ運用のためのリンクトデータに関するOCLC Research Library Partnership のプロダクトインサイト・セッション概要、AIを活用したメタデータ作成ワークフロー支援などの話題をお届けします。

『OCLC News』一覧 >

目次

―OCLC ResearchのブログHanging Togetherより (英語記事翻訳)―

WorldCatにおける重複排除の規模拡大: AI技術の革新的活用と目録作成の精度両立を目指して

2025年6月4日 – ベマル・ラジャパティラーナ

この画像は、AIを使用して生成した、私たちが重複スリップを保管していた雑然とした廊下の記憶の再現です。AIは、実際の状況よりもずっとすっきりとした見た目に仕上げています。

私たちは、2023年のブログ記事「Machine Learning and WorldCat (機械学習とWorldCat)」において、WorldCatにおける重複排除の改善に機械学習を活用する取り組みについてご初めてご紹介しました。

重複排除は、目録作成の効率化と品質管理の合理化を通じてWorldCatの品質を維持するために常に不可欠な要素でした。しかし、書誌データがかつてない速さで大量に投入される中で、レコードの正確性、関連性、アクセス性を迅速に維持する課題に対処する必要があります。AIを活用した重複排除は、この作業を迅速かつ効率的に拡大する革新的な方法を提供しますが、その成功は人間の専門知識に依存しています。OCLCでは、AIを活用して膨大なデータを処理しつつ、目録作成者やOCLCの専門家が意思決定の中心に据えられるよう、ハイブリッドな手法にリソースを投入してきました。

紙のスリップから機械学習へ

OCLCに所属するずっと前から、私は重複排除が完全に手作業で行われていた時代の書誌データ品質管理業務に携わっていました。図書館は「品質改善プログラム」の一環として、重複疑いのレコードを記載した紙のスリップを郵送し、それぞれに目録担当者の判断理由が記載されていました。私たちは、これらの色分けされたスリップを何千枚も、固定式のキャビネットに分類していました。緑は図書用、青は非図書用、ピンクはシリアル用です。溢れ返る重複スリップを収納するために、文房具用引き出しを再利用することもありました–そのためペンやノートを見つけるのが至難の業でした。

今思えば、それは先見の明のあるコミュニティの取り組みでした。しかし、その作業はゆっくりと、着実なもので、当時の私たちの根気強い努力を反映したものでした。個々のスリップは、システム内のレコードが統合されるか保持されるかを決定する人間の判断の産物でした。そして、このプロセスは、その努力にもかかわらず、本質的に規模の制約を伴っていました。私たちは常に重複を追いかけ、それを先回りするのではなく、後追いで対応していたのです。

現在、OCLCでAIを活用した重複排除作業に従事している中で、私たちはどれほど進歩したかを痛感しています。かつては数年かかっていた作業が、今では数週間で完了し、より高い精度で、これまで以上に多くの言語、文字体系、資料の種別に対応できるようになりました。しかし、この作業の核心は変わりません。人間の専門知識が重要なのです。AIは魔法の解決策ではありません。AIは私たちの目録基準、専門的な判断、そして修正から学習するのです。

重複排除にAIと人間の判断を組み合わせたハイブリッドアプローチを採用することで、機械学習が大量の処理を効率的に行いながら、人間の監視が処理を適切に導き、最適化することができます。

WorldCatにおける技術革新と責任ある管理活用とのバランスを保つ

数十年にわたり、目録担当者、メタデータ管理者、およびOCLCチームは、WorldCatの整合性を維持し、図書館と研究者にとって高品質で信頼できる資源として機能し続けるよう努めてきました。重複排除は、この取り組みの核心であり、効率性、発見可能性、および相互運用性を向上させるために、不要なレコードを取り除く役割を果たしてきました。

現在、AIは重複データの削除に新たな手法を可能にしており、大規模な重複レコードの特定と統合能力を飛躍的に拡大しています。しかし、最大の課題は単にAIをどう適用するかではなく、責任をもち、透明性を確保し、専門的な目録作成基準と一致した形でAIを活用する方法にあります。

この重複排除の規模拡大手法は、私たちが長年担ってきた共有書誌データ管理者の役割の延長線上にあります。AIは人間の専門知識を強化する機会を提供するものですが、それを置き換えるものではありません。

重複排除における根本的な変化

歴史的に見て、重複排除は目録担当者やOCLCスタッフによる決定的アルゴリズムと手作業に依存してきました。この方法は効果的ではありますが、限界があります。

OCLCのAIを活用した重複排除手法により、次のようなことが可能になります。

- 英語とロマンス諸語の枠を超えて—OCLCの機械学習アルゴリズムは、非ラテン文字の文字体系とレコードをすべての言語において正確かつ効率的に処理でき、グローバルなコレクション全体で大規模な重複排除を迅速に実行できます。

- 多様なレコードの種類に対応—AIは、幅広い種類の書誌レコードにおける重複を検出するだけでなく、対応が困難な特定の資料種別に関する新たな知見を提供します。

- 貴重資料、特殊コレクションのレコードを保護—現在、AIによる重複排除プロセスでは貴重資料に対して手を加えず、アーカイブや特殊コレクションに保存されている独自のレコードを保護しています。

これらの進歩により、より広い範囲の資料と言語にわたって、より正確なメタデータ作成が実現され、WorldCatにおけるメタデータ品質向上の取り組みを責任を持って拡大することが可能になります。

「責任あるAI」が実際に意味するもの

「AI」という用語は広範囲にわたるため、懐疑的な見方をされることがよくあります。それは当然のことです。多くのAIアプリケーションは、バイアス、精度、信頼性について懸念を引き起こしています。

私たちの方法は、以下のいくつかの基本的な考え方に基づいて構築されてきました。

- AIは人間の専門知識を補完するために存在し、置き換えるものではない。私たちは、AIモデルが目録作成におけるベストプラクティスを考慮して訓練されるよう、人間による検証とデータラベリングを組み合わせています。

- 効率を追求するあまり、正確性を犠牲にしてはならない。AIを活用した重複排除機能は、計算資源の最適化を目的として設計されており、自動化がレコードの品質を損なうことがないよう確保されています。

- 持続可能性は重要である。私たちの手法は計算効率を重視し、不必要なリソースの消費を削減しつつ、高品質な結果を維持するように設計されています。AIの資源使用量を最適化することで、重複排除が長期的にコスト効率的で拡大可能な状態を保つことを保証します。

この重複排除の方法は、人間の役割を削減するものではありません。むしろ、彼らの専門知識を最も重要な分野に再集中させるものです。目録担当者は、コミュニティとのつながりを深める高付加価値の業務に集中できるようになり、重複レコードの解決に何時間も費やす必要がなくなります。

さらに、目録担当者と経験豊富なOCLCスタッフは、このプロセスに積極的に参加しています。データラベリングとフィードバックを通じて、プロフェッショナルはAIの重複認識能力を精緻化し、向上させるのに貢献しています。

AIの協働的な取り組みと今後の展望

紙のスリップの山や四半期ごとのキャビネットの整理整頓は恋しくありませんが、それらが象徴していた価値は尊重しています。AIはあの手間を置き換えるのではなく、拡大しているのです。ツールは進化しても、私たちの原則は変わりません。OCLCは長年、図書館が目録とコレクションを管理するのを支援するために技術を活用してきました。現在、私たちは同じ考え方をAIに応用しています: 意図的で効果的であり、メタデータ品質への共通のコミットメントに基づいたものです。この革新への取り組みは、図書館が変化するニーズに対応し、利用者に価値を提供する力をもたらします。

OCLCのデータラベリング構想に今すぐご参加いただき、AIの重複排除における役割の最適化にご協力ください。

AIを活用した重複削除は、コミュニティの意見と専門家の監督のもと、継続的に進化していく共同の取り組みです。皆様の貢献は、WorldCatの品質と効率に直接的な影響を与え、図書館コミュニティ全体に利益をもたらします。

参加方法は以下の通りです

◆ データラベリングインターフェース(WorldShareのログイン資格情報が必要です)

◆ 参加要領

◆ よくある質問

OCLC事業部より: 日本の目録ユーザー様へ別途ご連絡いたしました「データラベリングプロジェクト」は6月末まで延長されました。

目次へ戻る▲

原文はこちらから>>

―OCLC ResearchのブログHanging Togetherより (英語記事翻訳)―

メタデータ運用のためのリンクトデータ : OCLC Research Library Partnershipのプロダクトインサイト・セッション概要

2025年4月10日 – アネット・ドルトムント

Photo by Wim Arys on Unsplash

2025年3月、WorldCat MARCにおけるWorldCat EntitiesリンクトデータURIの使用と再利用について、OCLC RLPメタデータマネージャー・フォーカスグループメンバー間で以前に行われた議論を受けて、グループは同じトピックに関する一連の「プロダクトインサイト」セッションのために再度会合を開きました。

3つの異なるセッションに、以下4カ国の30RLP機関から41人が参加しました。

| Art Institute of Chicago |

The New School |

University of Leeds |

| Binghamton University |

New York Public Library |

University of Manchester |

| Clemson University |

New York University |

University of Maryland |

| Cleveland Museum of Art |

Pennsylvania State University |

University of Pennsylvania |

| Cornell University |

Princeton University |

University of Pittsburgh |

| Library of Congress |

Tufts University |

University of Sydney |

| London School of Economics and Political Science |

University of California, Los Angeles |

University of Tennessee, Knoxville |

| Monash University |

University of Chicago |

University of Southern California |

| National Gallery of Art |

University of Hong Kong |

Virginia Tech |

| National Library of Australia |

University of Kansas |

Yale University |

「プロダクトインサイト」セッションとは、RLPのパートナーに対し、製品担当者が取り組んでいる業務に関する情報を独占的かついち早く提供し、その見返りとして、製品担当者が現場から適切な知見を得られるようにするものです。この日の主賓は、OCLCのメタデータおよびデジタルサービス担当シニア・プロダクト・マネージャーのジェフ・ミクスター氏でした。かつて、OCLC Researchチームのメンバーとしてリンクトデータの実験を行っていたジェフは、現在OCLCのリンクトデータ製品、アプリケーション、サービス開発を指揮しており、図書館のリンクトデータの実際の事例に関する対話に常に熱心に参加しています。

新しい機会を一歩ずつ、大規模に

ジェフはセッションの冒頭で、OCLCのリンクトデータ戦略について改めて説明しました。

- 彼のチームは、今もよく行われているように、リンクトデータをMARCからの自然な流れとして扱うのではなく、よりよいものと既定された新しい技術として捉え、今日のメタデータ運用における問題点や非効率性に注目し、リンクトデータがどのように問題解決や効率化に役立つのか、あるいは最も重要なこととして、今ここにはない新たな機会を引き出すことができるのかを調査している。

- チームの第二の目標は、メタデータとワークフローの変更を一歩ずつ、大規模に実施し、何十年もの間、MARCデータに依存してきたシステムやワークフローを混乱させることなく、徐々に達成すること。

- 第三に、ジェフは、図書館がリンクトデータへの移行においてどのような状況にあろうとも、また図書館の内的または外的な力によって図書館が変化する能力が制限されようとも、図書館をサポートすることを信念としている。その1つの方法として、WorldCatのMARC 21書誌レコードにWorldCat Entities URIを追加することで、「linky MARC」と呼ばれるものを作成している。WorldCat Entitiesは、図書館資料を記述する際に使用することができる、人、団体、およびその他の実体タイプのための、典拠性のあるリンクトデータ実体およびURIのセットである。これらのURIは、記述の枠組みにとらわれず、特定の文脈で優先的に使用されるデータモデルであれば、どのようなものでも使用することができる。WorldCatにWorldCat Entities URIを大規模に組み込むことで、リンクトデータへの移行に大きく前進している図書館を支援し、その途上にある図書館を力づけ、他のすべての図書館にMARCに依存しないメタデータの未来へ移行する出発点を提供することを目指している。

2つのサブフィールド$1と4.0、そして知っておくべきさらにいくつかの事実

* 4.0=クリエイティブ・コモンズ・ライセンス表示4.0 国際(CC BY 4.0)

製品洞察セッションの冒頭はOCLCのリンクトデータ作業についての具体的な質問への回答に充てられました。

WorldCat書誌レコード内のURI

ジェフの説明によると、OCLCは以下2つの方法でWorldCat書誌レコードにWorldCat EntitesのURIを追加しているとのことです。

- 特定のMARCフィールド (例えば、100, 651, 700) にURIを追加するためのレコード一括更新

- 特定の語彙から標目形に統制する通常のオフラインバッチ典拠管理サービス (目録作成ツール内のControl Single Heading機能) の一環として、候補となる標目が統制される際にURIを追加

2024年のOCLCの目録作成用製品の改良も、URIによるレコードの強化に役立っています。目録作成者が100および700フィールドで個人名標目を典拠管理する場合、URIは自動的に挿入されます。ある出席者は、生没年や職業での修飾語が付かない典拠管理済の個人名標目 (たとえば、「Eco, Umberto」) は、単に標目の典拠管理をいったん解除 (Uncontrol Single) し、再度典拠管理 (Control Single Heading) することにより、URIを簡単に追加できると話しました。目録作成者によるレコード内の単一の操作で、現在のMARCのニーズに対する標目の典拠管理と、将来のリンクトデータ機能への橋渡しの両方が可能になります。

ジェフは以前のセッションでの質問に答えて、OCLCはWorldCat Entities URIをMARCレコードのサブフィールド$1に置いていると説明しました。これは、通常典拠レコード番号を指すサブフィールド$0とは異なり、「Real World Objects (実世界オブジェクト)」 (RWOs) のためのURIが入るフィールドです。

$1のURIは、どの出力方法を選択しても、WorldCatから出力されるすべてのデータにデフォルトで含まれます。残念なことに、URIはWorldCatからいくつかの図書館サービスプラットフォームへ送られる途中で「失われて」しまいます。出席者は、取り込み時に$1サブフィールドのURIを不注意で落としていないか確認するため、データ提供者に働きかけるよう推奨されました。

利用規約

WorldCat Entitiesデータへのアクセスは階層化されており、認証されたユーザーは認証されていないユーザーよりもURIに対してより多くのデータセットを得ることができます。認証された利用者に必要なのは、OCLC開発者ネットワークから入手可能な無償のAPIキーだけです。アクセスのレベルに関わらず、データの使用はCC BY-NC 4.0ライセンスによって管理されます。これはWorldCat Entitiesウェブサイトの「利用規約」にも詳述されています。

データの来歴

WorldCat Entitiesデータを編集ツールMeridianで編集する際、情報源のURLを追加することで、個人の生年月日や専門分野など、データの来歴情報を個人の請求レベルで追加することができます。OCLCは記述の変更履歴を管理し、どの機関によってどのような変更が行われたかを記録します。

ワークフローへの導入

参加者からは、WorldCat Entities URIが現在の書誌作成ワークフローとどのように統合されるのかという質問がありました。上述の一括更新や強化に加えて、目録作成中にWorldShare Record ManagerでエンティティのURIを手動で検索して追加することもできますし、Meridianのご契約者であれば、その場でEntities URIを作成することもできます。この機能は、目録作成アプリケーションConnexionにも搭載される予定で、最終的にはCONTENTdmにも搭載されます。WorldCat Entities APIを使用することで、このようなタイプの統合は、開発作業さえ行われれば、どのような状況であれ、メタデータ作業に使用される他のツールでも実現することができます。

個人エンティティの利用 – はい、お願いします

これらの新しい情報が発表されたことで、参加者がより深く議論する準備が整いました。最初のトピックは、個人のエンティティと識別子を取り巻く具体的な価値と課題を探ることでした。

個人識別子は、ほとんどあらゆる場所で必要とされています。個人識別子により大して労力をかけずに、個人を曖昧さなく識別することができます。個人識別子を使えば、ある出版物について、対応する著者だけでなく、それ以上の著者を特定することも容易になります。ある参加者は、電子化された論文や学位論文では、教授や委員会メンバーなどの関係者だけでなく、複数の著者についてもORCID識別子を追加していると話していました。

典拠レコードの作成が一般的であっても、スタッフの問題や優先事項の競合により、この作業が大幅に遅れることがあります。図書館は、識別子を使用することにより著者の曖昧さを確実に排除する、より迅速な方法の検討に迫られます。

地域的な多様性は、個人エンティティの強力な推進力でもあり、何らかの理由で典拠レコードを持つことができなかった地域的な特性を明らかにし、曖昧さを解消したいという要望と、複数の地域言語でラベルを追加する必要性の両方を促進しています。Entities URIの追加は、確定標目が存在する場合、それに対立するものである必要はありません。リンクトデータURIは、少なくともWorldCatにおいては、特定の典拠のある標目を上書きすることはなく、ユーザーは両方の長所を享受できます。

でも …

その必要性と利点は明らかですが、… 残念ながら、障壁はいたるところにあるようです。

非常に具体的な障壁として議論されたのは、図書と論文における目録慣行の違いでした。図書の個人メタデータは厳密な典拠管理によって支配されていますが、論文レベルのデータはそうではなく、ファーストネームはしばしば引用形式に従ってイニシャルのみで記載されています。このため、これらのプラットフォームやデータソース間で著者を確実に照合し、一致させることはほとんど不可能です。

マッチングの問題がエンドユーザーに対しても可視化される領域は、ナレッジグラフ人物カードのような図書館サービスプラットフォームにおける実験的なリンクトデータ機能です。これらの機能は、典拠ファイルのような単一のソースにのみ依存していることが多く、著者がORCID識別子によって識別される機関リポジトリデータのような他のソースからの情報を拾わないため、不完全な人物カードになってしまいます。参加者の一人が指摘したように、そのような機能はリンクトデータに何ができるのか、そしてどこにまだギャップがあるのかを明らかにするのに有効なものです。

不完全な情報が悪いものだとすれば、不正確な情報はそれよりはるかに悪いものです。図書館は利用者に提示するデータの正確さに責任を感じており、外部データソースのエラーから生じる品質問題が図書館に悪い影響を与えることを懸念しています。ウィキデータのようにソース側でデータを修正しても、ターゲットとなるシステムの表示が即座に更新されるとは限りません。ある参加者は、修正されたウィキデータの情報が図書館サービスプラットフォームの人物カードに表示されるようになるまでに丸1ヶ月かかったと話しました。このような問題は、新しい製品機能において初めのうちだけに起こる問題かもしれませんが、その図書館にとっては警鐘を鳴らすものでした。

PIDが多すぎるのに時間がない

議論の大部分は、異なる個人識別子が多数あることによって生じる問題を中心に行われました。これらの識別子は、非常に限定された目的を果たし、特定の制限を持ち、特定のワークフローで使用されるときに最もよく機能します。その結果、図書館はある文脈ではORCID識別子を使い、別の文脈では典拠ファイルを使うことになります。そして、ウィキデータもあります。ウィキデータは、デフォルトのオプションが利用できない場合に、そのセットを補完する識別子のソースとして何度も言及されました。ある参加者は、「まだ一種の合切袋のようなものだ」と指摘しました。しかし、結果として生じた識別子の混合物は、容易に統合することができません。これが解決できれば、多くの運用上の問題は解決するでしょう。

リンクトデータの識別子を従来のメタデータと結合させる取り組みが進行中です。参加者の一人は、MARCレコードにORCID識別子を追加することが助けになるのではないかと考えています。他の機関ではORCIDやISNIの識別子を典拠レコードに追加しています。しかし、このような作業は有用であると考えられているものの、容易に規模を拡大することはできません。

私たちの議論は、その中間に位置し、すべてをつなぎ合わせることができるものを作るという選択肢を模索しました。多くの 「same as」関係を持つ識別子のハブは、各識別子が独自のコンテキストで機能することを可能にしますが、識別子を横断的に発見するために使用または参照することもできます。しかしながら、このハブのアイデアをワークフローに統合するためには、迅速かつ大規模に完全採用される必要があり、さらに、このようなソリューションに対する十分な信頼をどのように生み出すかという問題もある、と参加者は警告しています。ウィキデータのような大規模なプラットフォームでさえ、図書館で使用する識別子としては、長期的な戦略的選択肢として信頼される事はあまりありません。

この時点でジェフは議論に参加し、彼にとっても、識別子が互いにやり取りできるようにすることが目標であり、WorldCat Entitiesは図書館のサイロをつなぐための一種の架け橋として設計されたという彼の確信を共有しました。ちなみに彼のビジョンはWorldCatだけにとどまらず、彼は同僚と協力して、CONTENTdmのデジタル資料間や (主に新聞記事、雑誌記事、書籍の章である) OCLC Central Index内でのWorldCat Entities識別子の統合を開始しようとしています。

サイロおよびエンティティ間を横断する検索

ハブの有無にかかわらず、これらの問題を解決できたと仮定した場合、今できないことは何でしょうか?

- プラットフォーム間を横断して関連資料を簡単に検索

- 例えば、あるシステムで管理されている貴重な印刷資料のコレクションと、別のシステムで管理されている文化的コレクションの資料を横断的に発見できるように改善することができます。

- プラットフォーム間検索をローカル環境やシステム構成を超越して拡張し、より大規模な図書館リンクトデータのナレッジグラフを活用する

- 例えば、一次資料(前述の例では壁画)は、その画家の印刷著作や画家自身やその作品に関する著作などの二次資料と接続することができる。これは、リンクトデータ・エンティティを使用し、接続することによって可能になるはずの、より豊かな発見体験の一例です。

- この文脈では、文化遺産資料のリンクトデータ記述及び管理のモデルであるLinked Art Project(https://linked.art/)が言及されました。

- 思いがけない発見の実現

- 多くのコレクションは研究者が予期しない場所に存在しますが、ネットワークレベルの検索やブラウジングによって、それらを「発見」し、新しい方法で結びつけることができます。

このような新しい可能性を引き出すことが、おそらく図書館リンクトデータと真にグローバルなGLAM (美術館・図書館・公文書館・博物館) ナレッジグラフに期待される最大の成果の一つでしょう。

このブログ記事を書くにあたり、私をサポートしてくれたすべての人々、特に同僚のジェフ・ミクスター、ケイト・ジェームズ、レベッカ・ブライアントに感謝します。

目次へ戻る▲

原文はこちらから>>

―OCLC ResearchのブログHanging Togetherより (英語記事翻訳)―

AIを活用したメタデータ作成ワークフロー支援: OCLC RLP作業部会

2025年5月14日– メリリー・プロフィット

Photo by Antonino Visalli on Unsplash

メタデータ作成ワークフローに人口知能 (AI) を利用する可能性は急速に増しています。その結果、メタデータ管理者がAIを活用してチームの能力を強化するのを支援するための資源の必要性が高まっています。このような職業上の課題を解決するため、OCLC Research Library Partnership (OCLC研究図書館パートナーシップ=RLP) のメタデータ管理者フォーカスグループ (MMFG) は先日、メタデータワークフローにおけるAIの管理に関する作業グループを新設しました。作業グループの主な目的は、私たちの共通の好奇心を喚起し、重要な課題を特定し、メタデータ管理者がAIを業務プロセスに自信を持って取り入れることができるように支援することです。

このコミュニティ主導の取り組みは、RLPの過去のAI関連研究をベースにしており、具体的には「Responsible Operations: Data Science, Machine Learning, and AI in Libraries (責任ある運用: 図書館におけるデータサイエンス、機械学習、そしてAI」 (2019年)、メタデータ管理者による「AIへの準備」に関する議論 (2024年)、およびALA(2024年)におけるパネルディスカッション「メタデータの変革: AIへの準備」が該当します。この作業グループは、MMFGのメンバーがタイムリーな話題についてより深く学ぶ機会を提供します。

私たちの参加者募集に対して、イギリス、アメリカ合衆国、カナダ、オーストラリアから参加者が集まりました。最初の会議では、参加者が現在の業務フローにおけるAI利用をどのように捉えているか、時間をかけて聴取しました。具体的な内容は以下の通りです。

- AI によってワークフローの効率と効果を高めるにはどうしたらよいでしょうか。

- AIサービスは、簡略なレコードを作成することで、資料の滞貨を削減するのにどのように役立ちますか?

- AIが非ラテン文字の資料を扱う図書館を支援するためのベストプラクティスは何ですか?

- AIは、機関リポジトリ、研究データ/情報管理エコシステム、および文化遺産デジタル資産管理プラットフォームにおけるメタデータワークフローの強化にどのように活用できるでしょうか?

私たちは、メタデータ管理者たちが現在直面している課題の一部について議論しました。概ね、私たちの会話では次のような点に言及しました。

- 人材: メタデータ組織における変更管理の推進方法について、既存のスタッフを支援するだけでなく、将来の能力開発についても検討します。これには、スタッフが多様な目録作成ルールやベストプラクティスを適切に活用できるようにAIが支援する方法についての考察も含まれます。

- 経済的側面: サービス、研修、および将来の職員配置を含む図書館予算にAIへの財政支援をどのようにして組み込めるでしょうか。

- メタデータとプラットフォーム: メタデータ管理者は、AI プラットフォームと機能をどのように評価し、特にメタデータワークフローの特定の部分 (レコードの生成、品質管理、エンティティ管理/典拠管理など) にどう適用するかを理解できるでしょうか。

- コレクション: さまざまな種類の機械学習やAIについて学び、どの種類が異なるコレクションタイプに最も適しているかを理解する方法。例えば、コンピュータビジョンは写真のためのメタデータ生成に利用される一方、電子学位論文(ETDs)の主題分析には向いていない。

- 専門的な価値観と倫理観: メタデータ管理者は、専門的な価値観と倫理観を尊重し、コレクションを責任を持って持続的に保護し管理するとの約束を果たしながら、上記の課題や領域をどのように検討できるでしょうか。

これらのテーマは、現在定期的に開催されている以下3つの作業グループにおいてより詳細な検討の出発点として採用されました。

- 主要な目録作成ワークフロー

- 特殊/独自コレクションのメタデータ

- 機関リポジトリ

当作業部会のメンバーの皆様に、この重要な取り組みを推進してくださったことに感謝申し上げます!

- コロラド州立大学 ヘレン・ベア

- ピッツバーグ大学 マイケル・ボラム

- コーネル大学 ジェン・コルト

- リーズ大学 エリー・コープ

- カルガリー大学 スーザン・ダール

- オーストラリア国立図書館 ミケラ・グッドウィン

- ネルソン・アトキンス美術館 アマンダ・ハーラン

- カンザス大学 ミロシェ・コットマン

- シドニー大学 チンミー・ラム

- ニューヨーク大学 ヤシャ・ラジザデ

- 国立公文書記録管理局 ジル・ライリー

- 大英図書館 ミア・リッジ

- イェール大学 ティム・トンプソン

- ラトガース大学 メアリー・ベス・ウェーバー

- プリンストン大学 キャシー・ウェン

- ロンドン・スクール・オブ・エコノミクス ヘレン・ウィリアムズ

作業は6月末までに完了する予定で、調査結果については後日ブログ記事で詳しくお伝えする予定です。どうぞお楽しみに!

目次へ戻る▲

原文はこちらから>>

シリーズ: OCLCあの時この時 (10)

FBIが大学図書館にワケあり貴重書を寄贈!?

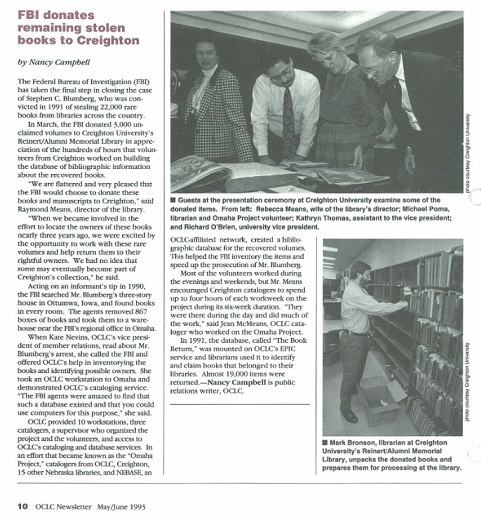

最後は、OCLC Newsletter No. 203 (May/June 1993)より、OCLCカタロガーの作業によって盗まれた貴重書が本来の持ち主である図書館に戻ったという話題を

1990年、米国連邦捜査局(FBI)は、全米の図書館から2万2,000冊の貴重書が盗まれた事件で、容疑者の自宅から押収した867箱の本をネブラスカ州オマハのFBI地域事務所に近い倉庫に運びました。

当時のケイト・ネビンズOCLC会員担当副社長は、容疑者逮捕に関する報道を読み、FBIに連絡、OCLCの協力を申し出て、貴重書の台帳作成と所蔵館の特定を支援しました。彼女はOCLCのワークステーションをオマハに持ち込み、OCLCの目録作成サービスを実演しました。

「FBIの捜査官たちは、そのようなデータベースが存在し、この目的でコンピュータを使用できることに驚いていました。」と彼女は述べています。

OCLCは10台のワークステーション、3人の目録作成者、プロジェクトとボランティアを統括する監督者、およびOCLCの目録作成とデータベースサービスへのアクセスを提供しました。この取り組みは「オマハ・プロジェクト」として知られるようになり、OCLC、クレイトン大学、ネブラスカ州の15の図書館、およびOCLC関連ネットワークであるNEBASEの目録作成者が協力し、回収された貴重書のための書誌データベースを作成、これによりFBIは盗品の台帳作成を効率化し、容疑者の起訴手続きを迅速化することができました。

1991 年、このデータベース「The Book Return」が OCLC の EPIC サービス (当時存在した図書館員向け情報検索サービス–その後FirstSearchに統合) に導入され、図書館員たちはこのデータベースを利用して、自館の所蔵図書を確認し、返却を請求しました。その結果、約 19,000 点の図書が返却されたのです。

同年3月、FBIは回収された図書の書誌情報データベース作成に数百時間をかけて協力したクレイトン大学のボランティアへの感謝の意を表し、同大学のレインハート/同窓会記念図書館に、所蔵館不明の3,000冊を寄贈しました。

「FBIがこれらの図書と手稿をクレイトンに寄付してくれたことは、私たちにとって光栄で大変嬉しく思います」と、図書館長のレイモンド・ミーンズ氏。「約3年前にこれらの資料の所蔵館を探し出す取り組みに参加した際、これらの貴重書と関わり、正当な所有者に返還する機会を得られたことに興奮しました。一部が最終的にクレイトン大学のコレクションの一部となる可能性は、当初は想像もしていませんでした。」

OCLC Newsletter No. 203 (May/June 1993)の記事

このオマハ・プロジェクトについては、アメリカ合衆国司法省司法計画室にビデオでの記録が残っているようです。残念ながらビデオを閲覧することはできませんが、以下のようなビデオ内容の要約が司法計画室のサイトに記載されています。

(抜粋訳)

このプロジェクトでは、44人の目録作成者と参考図書係のボランティアが、4週間の期間中に重さにして19トンの貴重書、手稿、インキュナブラの目録作成に600時間を費やしました。動画では、OCLCを検索し、93-95%のヒット率で各資料の詳細な書誌的記述と所蔵館候補のリストを作成したプロセスが説明されています。チームメンバーは、通常は間近で見る機会がない資料を手に取ったり見たりできることは名誉だと感じ、また、これらの資料を所蔵館に戻すことは図書館員の義務でもあると述べています。

ボランティアの皆さんにとっては忘れがたい経験になった事でしょう。この容疑者の自宅には、2万2,000冊の本を置ける場所があったという事実にも驚きです。

目次へ戻る▲

OCLC Newsletter No. 203 (May/June 1993) の該当記事はこちらから>>

(OCLC事業部)

掲載の商品・サービスに関するお申し込み・お問い合わせ先

株式会社紀伊國屋書店 OCLC事業部

電話:03-6910-0514 e-mail:oclc@kinokuniya.co.jp